📣 공지사항

[8월 1일]

◼︎ 8월 1일 플랫폼 리뉴얼 이후 새로운 파이썬 패키지를 업데이트 해야 제출이 가능하게 되었습니다!

◼︎ 1.8.0 으로 파이썬 패키지를 업그레이드 하여 제출 부탁드립니다 :)

튜토리얼 소개

AI 모델을 개발하면 곧 바로 채점이 된다고..?

추론 자동화 태스크, 튜토리얼로 쉽게 따라해보세요 !

Q. 추론 자동화가 뭔가요?

A. 경진대회에서 추론 자동화는 인공지능팩토리가 참가자의 인공지능 모델을 그대로 받아 이를 추론하고 평가할 수 있게 하는 기술 입니다.

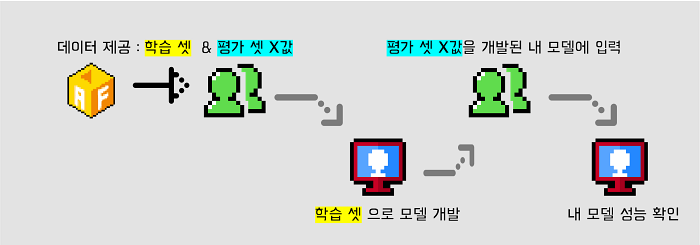

이전까지 인공지능 대회를 개최할 때 AIF는 참가자에게 학습셋 데이터와 함께 평가셋의 x값에 해당하는 데이터를 제공 했는데요,

그러면 참가자는 학습 데이터셋으로 모델을 개발한 후 자신의 모델에 평가셋 x값 데이터를 넣어서 나오는 결과값 y를 AIF에 제출했습니다.

이후 그 결과값 y는 AIF가 보유하고 있는 (=정답에 해당하는) y값과 비교되어 채점된 후 그 점수가 리더보드에 기록 되었는데요,

‘정답지 y값과 가장 유사한 y값을 도출한 참가자의 모델 성능이 더 좋다’ 라고 판단해온 것이죠.

추론 자동화 개발 전, 참가자는 평가 데이터셋의 x값을 넣어서 나온 y값(=Model Result)으로 모델 성능을 평가 받았습니다.

그러나 이렇게 평가셋 x값 데이터를 제공하는 경우, 아무리 x값만 제공된다 할지라도 정답지의 일부가

노출된다는 지적을 피하긴 어려웠습니다 (물론 저희 AIF의 엄격한 재현검증 방식으로 이러한 문제들을 예방 해왔지만요!).

또한 대회에서 제공된 평가셋 데이터에 대해서만 모델 성능이 좋게 나타나는 과적합(오버피팅) 현상이 일어날 가능성이 높았고

참가자가 여러 번의 시도를 통해 실제 정답을 유추해 볼 수도 있는 등 아쉬운 부분이 있었습니다 🥲

– BUT, IT'S DIFFERENT NOW! --

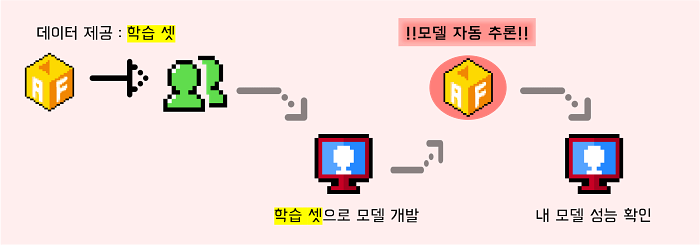

이제는 평가셋 데이터를 일절 공개하지 않고 AIF 플랫폼에서 참가자가 개발한 모델 그대로를 추론해 성능을 채점할 수 있으니까요 🌈

추론 자동화 개발 후, 참가자는 개발한 모델 그대로를 제출해서 모델 성능을 평가 받을 수 있습니다!

튜토리얼 이용 방법

지금 바로 ‘베이스라인’ 탭에서 코드를 실행해보세요!

추론 자동화 기술이 접목된 태스크는 기존 채점 방식과 살짝 달라 처음엔 헷갈릴 수 있지만,

베이스라인 코드에 자세하게 기재된 규칙을 하나 둘 따라 성공적으로 제출했다면 본인의 점수가 리더보드에 찍히는 것을 경험할 수 있답니다 ☺️

튜토리얼 그 후…

흠, 튜토리얼은 너무 쉬웠다구요? 🤔

그럴줄 알고 진짜 AI 모델을 개발한 뒤 추론 자동화 기술을 이용해 결과를 제출해 볼 수 있는 문제 3개를 준비했답니다 ~ 아래 3개 분야에서 마음에 드는 태스크를 골라 참여해보세요!

항상 열려있는 태스크이기 때문에 내가 원할 때 언제든 접속해서 점수를 기록해 볼 수 있어서,

모델 개발 연습도 해보고 앞으로 많은 AI 경진대회에 접목될 추론 자동화 기술도 먼저 경험해 보시길 바랍니다 !

- 이미지 분야 | 꽃 품종 데이터셋을 활용한 이미지 분류 태스크

- 자연어 분야 | 네이버 영화 리뷰 데이터셋(nsmc)을 활용한 감성 분류 태스크

- 시계열 분야 | Household Power Consumption(UCI Machine Learning Repository) 데이터셋을 활용한 글로벌 유효 전력 소비량 예측 태스크

문의처

- 본 페이지 상단의 Q&A 탭에서 질문을 남기실 수 있습니다.

===  여러분의 많은 시도 부탁드립니다

여러분의 많은 시도 부탁드립니다  ===

===