SPACE-S

팔로워10명

주최대회0개

Competition

전체보기

종료

제6회 2024 연구개발특구 AI SPARK 챌린지

SPACE-S

1600만원

제6회 2024 연구개발특구 AI SPARK 챌린지

SPACE-S

1600만원

종료

제5회 2023 연구개발특구 AI SPARK 챌린지 - 사회문제해결형

SPACE-S

800만원

제5회 2023 연구개발특구 AI SPARK 챌린지 - 사회문제해결형

SPACE-S

800만원

종료

안내 | 제5회 2023 연구개발특구 AI SPARK 챌린지

SPACE-S

800만원

안내 | 제5회 2023 연구개발특구 AI SPARK 챌린지

SPACE-S

800만원

종료

제4회 2023 연구개발특구 AI SPARK 챌린지 - 공기압축기 이상 판단

SPACE-S

800만원

제4회 2023 연구개발특구 AI SPARK 챌린지 - 공기압축기 이상 판단

SPACE-S

800만원

종료

안내 | 제4회 2023 연구개발특구 AI SPARK 챌린지

SPACE-S

800만원

안내 | 제4회 2023 연구개발특구 AI SPARK 챌린지

SPACE-S

800만원

종료

[2023 연구개발특구 AI SPARK 챌린지] 인공지능 경진대회 수요기업 모집

SPACE-S

[2023 연구개발특구 AI SPARK 챌린지] 인공지능 경진대회 수요기업 모집

SPACE-S

종료

[2023 연구개발특구 AI SPARK 챌린지] 인공지능 경진대회 온라인 설명회

SPACE-S

[2023 연구개발특구 AI SPARK 챌린지] 인공지능 경진대회 온라인 설명회

SPACE-S

Learning

전체보기

진행중

제6회 2024 연구개발특구 AI SPARK 챌린지 수상 모델 공개

SPACE-S

제6회 2024 연구개발특구 AI SPARK 챌린지 수상 모델 공개

SPACE-S

종료

매너스 심층분석 오프라인 세미나

SPACE-S

매너스 심층분석 오프라인 세미나

SPACE-S

종료

생성형 AI를 활용한 문서 자동화 및 콘텐츠 생성 전략

SPACE-S

생성형 AI를 활용한 문서 자동화 및 콘텐츠 생성 전략

SPACE-S

종료

AI Agent, 스타트업의 게임체인저

SPACE-S

AI Agent, 스타트업의 게임체인저

SPACE-S

종료

생성형 AI를 활용한 경영 데이터 분석

SPACE-S

생성형 AI를 활용한 경영 데이터 분석

SPACE-S

종료

[25년 1월 7일] 생성형 AI를 활용한 콘텐츠 마케팅 자동화의 거의 모든 것

SPACE-S

[25년 1월 7일] 생성형 AI를 활용한 콘텐츠 마케팅 자동화의 거의 모든 것

SPACE-S

종료

[대덕특구] SPACE-S 생성형AI 세미나 안내

SPACE-S

[대덕특구] SPACE-S 생성형AI 세미나 안내

SPACE-S

Training

전체보기

진행중

알파벳 수화 직접 배워보기

SPACE-S

알파벳 수화 직접 배워보기

SPACE-S

진행중

숫자손글씨 직접 분류해보기

SPACE-S

숫자손글씨 직접 분류해보기

SPACE-S

진행중

패션 아이템 이미지 분류하기

SPACE-S

학습용

패션 아이템 이미지 분류하기

SPACE-S

학습용

진행중

머신러닝을 통한 당뇨병 예측

SPACE-S

머신러닝을 통한 당뇨병 예측

SPACE-S

진행중

딥러닝으로 은하 분류하기

SPACE-S

딥러닝으로 은하 분류하기

SPACE-S

진행중

리뷰 데이터 감성 분석

SPACE-S

리뷰 데이터 감성 분석

SPACE-S

진행중

타이타닉 생존자 예측하기

SPACE-S

타이타닉 생존자 예측하기

SPACE-S

Chat

전체보기Forum

전체보기

SPACE-S 세미나 : 생성형AI를 활용한 생산성 향상 방안

안녕하세요. 김태영입니다. 생성형AI를 활용한 생산성 향상 방안이라는 주제로 SPACE-S 세미나를 2024년 7월 2일 16:10~17:00에 대전 SPACE-S AI 코워킹스페이스에서 발표합니다. 주제는 생성AI트렌드와 활용사례 소개이긴 하나 활용사례 중에 스타트업에서 활용 가능한 고객관리, 프로젝트 관리, 액션아이템 관리 쪽으로 발표할 예정입니다. 많은 관심 부탁드립니다. 신청링크 : https://event-us.kr/spaces/event/86347

MIoU 평가지표

MIoU 평가지표안녕하세요 저는 Semantic Segmentation의 대표적인 평가지표 MIoU에 대해 소개해드리려고 합니다.먼저 IoU(Intersection over Union)는 실제 객체가 존재하는 박스와 모델이 객체라고 인식한 박스가 얼마나 차이 나는지를 표현한 값으로 다음과 같이 나타낼 수 있습니다.즉 객체라고 인식한 박스와 실제 객체가 존재하는 박스의 합집합 중 교집합이 속하는 영역의 넓이로 볼 수 있는데요 예를 들어 다음과 같이 초록색 박스(GT) 와 모델이 평가한 빨간색 박스가 있다고 가정할 때(infered) 초록색 박스 크기와 빨간색 박스 크기를 합한 넓이 중 두 박스가 겹치는 부분의 넓이가 차지하는 비율을 구하여 IoU를 구할 수 있습니다. Object Detection task에서는 IoU의 값이 1에 가깝다는 의미는 두 박스가 일치하다는 뜻과 일맥상통하기에 1에 가까울수록 좋은 성능을 가진다고 평가합니다. *Overlapping Area(교집합 영역 넓이)*Union area(합집합 영역 넓이): area(green box)+area(red box) - Overlapping Area 그렇다면 MIoU란 무엇일까요?MIoU란 mean Intersection over Inion으로 IoU의 평균 값을 의미합니다. 보통 모델은 여러가지 평가 데이터 셋을 통해 평가되어지는데 결국 좋은 성능인 모델이라고 말하기 위해서 많은 평가 데이터에 대해 높은 IoU 값을 보여야 합니다. 따라서 모델의 평균 성능을 평가하기 위해 이미지에 대한 IoU값을 측정한 후 평균을 계산하여 MIoU를 구하게 되는 것입니다. 위와 같은 평가 지표는 Object Detection 또는 Semantic Segmentation 모델에 대해 성능 평가 지표로 많이 사용됩니다.

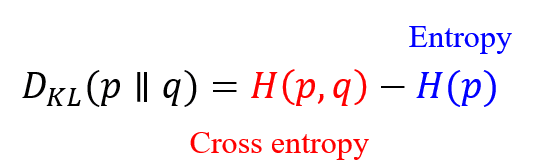

What kind of loss function do we have to use?

손실함수는 신경망 모델이 각 훈련 배치에서 전체 오류를 계산하는 방법을 정의합니다. 따라서 역전파를 수행할 때 내부 가중치가 조정되는 과정에 영향을 미치므로 전체 모델 성능에도 중요한 영향을 미칩니다. 이미지 분할 및 분류 작업에 대한 기본적인 손실 함수는 BCE ( 이진 교차 엔트로피 ) 입니다. Dice 계수 혹은 IoU 손실 함수가 사용되는 상황에서도 기본적인 베이스라인으로 BCE를 사용합니다. 손실 함수는 역전파가 거슬러 올라가는 동안 모델 전체에서 계산되어야 하는 텐서에서 작동해야 하므로 Numpy로 간단하게 계산될 수 없습니다. 해당 모델 라이브러리에서 제공하는 함수를 사용해야 합니다. Keras에서는 k.sum()과 같은 함수를 사용합니다. 그라디언트 계산은 모델 라이브러리에 의해 자동으로 계산되지만, 필요한 경우 수동으로 정의할 수 있습니다. 다중 클래스 분류 및 분할에서는 전체 손실대신에 각 클래스의 평균 손실을 계산하는 손실 함수를 사용합니다. 1. Distributation-based loss ( 분포 기반 손실 함수 )Cross entropy (CE) 크로스 엔트로피는 Kullback-Leibler(KL) divergence라는 두 분포 사이의 비유사성에 대한 측정값입니다. 일반적인 기계 학습에서는 데이터 분포는 훈련 데이터에의해 제공되므로 H(p)는 상수입니다.가중 교차 엔트로피는 CE의 확장된 버전으로 각 클래스에 다른 가중치를 할당합니다. 일반적으로 제시되지 않은 클래스에는 더 큰 가중치가 할당됩니다.TopK loss는 네트워크가 훈련 중에 까다로운 샘플에 집중하도록 하는 것을 목표로 합니다.초점 손실은 잘 분류된 예제에 할당된 손실이 감소되는 극단적인 전경-배경 클래스 불균형을 처리하기 위해 표준 CE를 적용합니다.거리 패널티 CE 손실 가중치는 실제 마스크에서 파생된 거리 맵에 의해 엔트로피를 교차합니다. 분할하기 어려운 경계 영역으로 네트워크의 초점을 안내하는 것을 목표로 합니다. 2. BCE-DICE Loss (BCE-Dice 결합 손실 함수) 이 손실은 이미지 분할 모델 손실 함수로서 기본값인 표준 이진 교차 엔트로피(BCE) 손실과 주사위 손실을 결합합니다. 두 가지 방법을 결합하면 손실의 다양성을 허용하면서 BCE의 안정성을 활용할 수 있습니다. 다중 클래스 BCE에 대한 방정식 자체는 로지스틱 회귀를 연구자에게 친숙한 개념이다. 3. Region-based loss (영역 기반 함수)영역 기반 손실 함수는 정답과 예측된 분할 간의 불일치를 최소화하거나 중첩 영역을 최대화하는 것을 목표로 합니다.민감도-특이성(SS) 손실은 민감도와 특이성의 평균 제곱 차이의 가중치 합입니다. 불균형 문제를 해결하기 위해 SS는 특이성에 더 높은 가중치를 부여합니다.주사위 손실은 가장 일반적으로 이미지 분할에 사용되는 평가 지표인 주사위 계수를 직접 최적화합니다.Dice 손실과 유사한 IoU 손실(Jaccard 손실이라고도 함)은 세분화 메트릭을 직접 최적화하는 데에도 사용됩니다.Tversky 손실은 FN(False Negative) 및 FP(False Positive)에 서로 다른 가중치를 설정합니다. 이는 FN 및 FP에 대해 동일한 가중치를 사용하는 주사위 손실과 다릅니다.일반화된 주사위 손실은 각 클래스의 가중치가 레이블 빈도의 제곱에 반비례하는 Dice 손실의 다중 클래스 확장입니다.초점 트버스키 손실은 초점 손실의 개념을 적용하여 확률이 낮은 희귀한 케이스에 초점을 맞춥니다.페널티 손실은 일반화된 주사위 손실에서 위음성 및 위양성에 높은 페널티를 제공하는 손실 함수입니다. 4. Dice Loss주사위 계수는 가장 일반적으로 이미지 분할에 사용되는 평가 지표이며, 이에 최적화 된 손실 함수입니다. 5. Jaccard/Intersection over Union (IoU) Loss -> IoU 손실 함수IoU 평가 지표는 주사위 지표와 비슷하며 교집합 대비 합집하의 비율로 계산된다. 주사위 지표와 함께 이미지 분할 모델에서 가장 많이 쓰이는 지표(수단)이다. 6. Focal LossFocal Loss는 2017년 Facebook AI Research의 Lin et al에 의해 양성 사례가 상대적으로 드물었던 극도로 불균형한 데이터 세트를 해결하기 위한 수단으로 도입되었습니다. 그들의 논문 "Focal Loss for Dense Object Detection"은 https://arxiv.org/abs/1708.02002에서 검색할 수 있습니다. 실제로 연구원들은 함수의 알파 수정 버전을 사용했기 때문에 이 구현에 포함시켰습니다. 7. Tversky Loss트베르스키 손실은 https://arxiv.org/abs/1706.05721 에서 검색할 수 있는 "3D 완전 컨볼루션 심층 네트워크를 사용하는 이미지 분할을 위한 Tversky 손실 함수"에 소개되었습니다. 손실 함수에서 서로 다른 유형의 오류가 얼마나 심하게 처벌되는지를 조정할 수 있는 상수를 활용하여 불균형 의료 데이터 세트에 대한 분할을 최적화하도록 설계되었습니다. 논문에서:... α=β=0.5의 경우 Tversky 지수는 F1 점수와 동일한 주사위 계수와 동일하도록 단순화됩니다. α=β=1일 때 방정식 2는 Tanimoto 계수를 생성하고 α+β=1로 설정하면 Fβ 점수 세트를 생성합니다. β가 클수록 정밀도보다 재현율이 더 높습니다(위음성에 더 중점을 둠).요약하자면, 이 손실 함수는 값이 증가함에 따라 손실 함수에서 더 높은 정도로 위양성 및 위음성 각각에 페널티를 주는 상수 '알파' 및 '베타'에 의해 가중치가 부여됩니다. 특히 베타 상수는 모델이 매우 보수적인 예측을 통해 오도할 정도로 긍정적인 성능을 얻을 수 있는 상황에서 적용됩니다. 최적의 값을 찾기 위해 다양한 값으로 실험할 수 있습니다. alpha==beta==0.5에서 이 손실은 Dice Loss와 동일해집니다. 8. Focal Tversky Loss트베르스키 손실의 변형으로서 초점 손실의 감마 수정자를 포함한다. 9. Lovasz Hinge Loss로바즈 힌지 손실 함수는 Berman, Triki 및 Blaschko의 논문 "The Lovasz-Softmax loss: A tractable surrogate for optimize of cross-over-union measure in neural network"에서 소개되었으며 여기에서 검색할 수 있습니다: https://arxiv.org/abs/1705.08790.특히 다중 분류의 경우 의미론적 분할을 위해 Intersection over Union 점수를 최적화하도록 설계되었습니다. 특히 각 오류가 IoU 점수에 미치는 영향을 누적 계산하기 전에 오류를 기준으로 예측을 정렬합니다. 그런 다음 이 그래디언트 벡터에 초기 오류 벡터를 곱하여 IoU 점수를 가장 많이 감소시킨 예측에 가장 강력한 페널티를 부여합니다. 이 절차는 jeanderbleu의 탁월한 요약 에서 자세히 설명되어 있습니다.이 코드는 https://github.com/bermanmaxim/LovaszSoftmax 작성자의 github에서 직접 가져왔으며 모든 크레딧은 이들에게 있습니다.원본 손실 함수 외에도 PyTorch에 대한 입력으로 재구성된 랭크 1 텐서를 사용하는 플랫 변형을 구현했습니다. 필요에 따라 데이터의 차원과 클래스 번호에 따라 수정할 수 있습니다. 이 코드는 원시 로짓을 사용하므로 손실 계산 전에 모델에 활성화 레이어가 포함되어 있지 않은지 확인해야 합니다.간결함을 위해 연구원의 코드를 아래에 숨겼습니다. 손실이 작동하려면 커널에 로드하기만 하면 됩니다. tensorflow 구현의 경우 여전히 Keras와 호환되도록 노력하고 있습니다. Tensorflow와 Keras 함수 라이브러리 사이에는 이를 복잡하게 만드는 차이점이 있습니다. 10. Combo Loss콤보 손실은 Taghanaki 등의 논문 "Combo loss: Handling input and output 불균형 in multi-organ segmentation"에서 소개되었으며 여기에서 검색할 수 있습니다: https://arxiv.org/abs/1805.02798.콤보 손실은 Tversky 손실과 마찬가지로 거짓 긍정 또는 거짓 부정에 각각 페널티를 주는 추가 상수가 있는 수정된 교차 엔트로피 함수와 주사위 손실의 조합입니다.( 결합 함수) 11. Boundary--based loss최근 새로운 유형의 손실 함수인 경계 기반 손실은 정답과 예측 간의 거리를 최소화하는 것을 목표로 합니다. 일반적으로 더 나은 결과를 위해서 경계 기반 손실 함수가 영역 기반 손실과 함께 사용됩니다. 12. Compound loss여러종류의 손실함수를 결합함으로서, 우리는 혼합된(결합된) 손실 함수를 얻을 수 있습니다. (ex Dice+CE, Dice + Focal, Dice + IOU )... 모든 종류의 손실 함수들은 플러그 방식으로(조립 및 결합) 사용할 수 있습니다.

Instruction Tuning LLM

The Limits of LLMs First, let’s briefly review how Large Language Models (LLMs) are created. A variety of text data, such as news, blogs, novels, technical books, and subtitles, is collected. This data undergoes various preprocessing steps like cleaning and deduplication to create the training dataset. This dataset is then fed into an empty LLM shell, training it to predict the next word in a sequence. This trained LLM can then use the input data to predict outcomes, and by feeding its outputs back as inputs, it can generate extended sequences of text. While the actual development process of LLMs is far more complex and involves many tasks, this simplification helps illustrate the general flow. We refer to such completed models as pre-trained or foundation models.Despite the vast knowledge and information accumulated within these pre-trained models, there is a significant issue in retrieving this knowledge effectively. As you might have noticed during the training description, LLMs based on the GPT architecture learn statistical patterns from massive text data and predict subsequent information based on previous data—a causal language model. Thus, they don't combine knowledge contextually like humans but generate the next word based on probabilities from preceding sentences.For example, if given the input "King Sejong using a MacBook," a typical pre-trained model might unabashedly generate "King Sejong made a report using a MacBook," because "report" was the statistically likely next word following "MacBook."This phenomenon, known as hallucination, is a fundamental issue with GPT-based LLMs. Various methods are being explored to address these challenges, with fine-tuning and in-context learning being the most common. Before discussing instruction tuning, let’s delve into these two techniques.In-Context Learning vs. Fine-Tuning Fine-tuning, discussed in a previous post, involves updating the model with a specific dataset to produce desired outputs. In-context learning, or prompt learning, recognizes the contextual meaning within a prompt and generates outputs accordingly. This approach tries to achieve desired outputs without updating the model but by crafting well-designed prompts.Examples of In-Context Learning:Zero-shot learning: The model answers a task immediately without prior examples.Prompt: "Analyze the emotion of the sentence: 'This movie is so boring.'"GPT: "It expresses a negative emotion."One-shot learning: The model performs a task with one example.Prompt: "This movie is so boring" -> Negative "This movie was dull" ->GPT: NegativeFew-shot learning: If one example isn’t enough, several are given.Prompt: "This movie is so boring" -> Negative "This movie is just okay" -> Neutral "This movie was really fun?" -> Positive "This movie is exciting" ->GPT: PositiveGPT-3 and other large LLMs can adapt to unseen data through prompts, leveraging their extensive knowledge and linguistic capabilities. Prompt engineering involves meticulously crafting prompts to extract and properly format the model’s output according to user intent.Instruction Tuning Combining the benefits of both fine-tuning and in-context learning, instruction tuning aims to enhance the model’s flexibility and accuracy. It involves training the model with a dataset comprising specific instructions and appropriate model responses, enabling the model to respond correctly to direct queries and elaborated instructions, much like in-context learning with example-based guidance.Alpaca A prominent example of applying instruction tuning to LLMs is Stanford’s Alpaca model, based on Meta’s LLaMA and fine-tuned with an instruction-based dataset. Initially, human-generated instruction samples guided the dataset creation, significantly reducing the time and effort involved by subsequently allowing the LLM (like GPT-3) to generate similar datasets itself (self-instruction).

Semantic Segmentation Paper List

Semantic Segmentation task와 관련하여 읽어볼 만한 CVPR2024 논문들입니다. 관심있으신 분들은 논문을 직접 읽어 봐도 좋을 것 같습니다. SemiCVT: Semi-Supervised Convolutional Vision Transformer for Semantic Segmentation HPL-ESS: Hybrid Pseudo-Labeling for Unsupervised Event-based Semantic Segmentation Frequency-Adaptive Dilated Convolution for Semantic Segmentation ContextSeg: Sketch Semantic Segmentation by Querying the Context with Attention SED: A Simple Encoder-Decoder for Open-Vocabulary Semantic Segmentation

베이스라인 함수 분석

1. 이미지 및 마스크 처리 함수1.1 get_img_arr(path)이 함수는 지정된 경로에서 이미지 파일을 열고, Rasterio 라이브러리를 사용하여 이미지 데이터를 읽습니다. 이 데이터는 (높이, 너비, 채널) 형식으로 변환되고, 모든 픽셀 값은 최대 픽셀 값(65535)으로 정규화됩니다. 정규화는 모델 학습에 있어 일반적으로 중요한 단계로, 다양한 이미지 간의 밝기 및 대비 차이를 줄이고 모델의 수렴 속도를 향상시키는 데 도움이 됩니다.1.2 get_img_762bands(path)이 함수는 특정 밴드(7, 6, 2) 데이터만 불러오는 특화된 버전입니다. 일부 위성 이미지 처리에서는 특정 밴드가 특정 유형의 정보(예: 식생, 수분, 지형 등)를 포함하고 있어 이 밴드들만 사용하여 모델을 학습시키기도 합니다. 이 함수 역시 데이터를 정규화하여 반환합니다.1.3 get_mask_arr(path)마스크 데이터를 처리하는 이 함수는 마스크 이미지(일반적으로 지상 진실 데이터를 나타냄)를 불러와 배열로 변환합니다. 이 데이터는 일반적으로 픽셀별 분류 작업(예: 픽셀이 특정 클래스에 속하는지 여부)에 사용됩니다.2. 데이터 제너레이터2.1 threadsafe_generator(f)멀티스레딩 환경에서 데이터 로드 작업을 안전하게 처리하기 위해 사용하는 데코레이터입니다. 파이썬에서 제너레이터는 기본적으로 스레드 안전하지 않기 때문에, 이 데코레이터를 통해 여러 스레드에서 동시에 접근해도 문제가 발생하지 않도록 합니다.2.2 generator_from_lists(images_path, masks_path, batch_size=32, shuffle=True, random_state=None, image_mode='10bands')이 함수는 이미지와 마스크의 경로 리스트를 입력으로 받아, 배치 단위로 데이터를 불러와 반환하는 제너레이터를 생성합니다. shuffle 옵션을 사용하여 데이터를 무작위로 섞어, 각 배치가 다양한 데이터를 포함하도록 하여 과적합을 방지합니다. image_mode 파라미터를 통해 사용할 이미지 처리 함수를 선택할 수 있습니다(get_img_arr 또는 get_img_762bands).3. 모델 훈련 및 검증3.1 모델 훈련(fit_generator)fit_generator는 제너레이터를 통해 생성된 데이터를 사용하여 모델을 훈련합니다. 이 함수는 에폭 수, 배치 크기, 검증 데이터 등을 설정할 수 있으며, EarlyStopping과 ModelCheckpoint 콜백을 사용하여 훈련 중 조기 종료와 최고 성능 모델의 저장을 관리합니다.4. 예측 및 결과 저장4.1 예측 실행훈련된 모델을 사용하여 테스트 데이터셋에 대한 예측을 수행합니다. 각 이미지에 대해 모델은 해당 픽셀이 특정 클래스에 속하는지 예측하며, 결과를 이진 마스크로 변환합니다. 여기서 임계값 처리는 모델 출력을 명확한 클래스 레이블로 변환하는 데 사용됩니다.4.2 결과 저장예측된 결과를 딕셔너리로 관리하고, 이를 파일로 저장합니다. 이 파일은 나중에 성능 평가나 시각화 등에 사용될 수 있습니다.

MMSegmentation

다양한 segmentation 모델을 구축해둔 MMSegmentation에 대해 소개하고자 합니다. github link : https://github.com/open-mmlab/mmsegmentation MMSegmentation은 OpenMMLab 오픈소스 프로젝트 팀이 구축한 segmentation 관련 라이브러리 입니다.Segmentation에서 널리 사용되는 다양한 모델, 데이터 셋, metric, visualize tool 까지 제공 합니다.Config 파일을 통해 본인이 원하는 모델 및 데이터 셋을 사용할 수 있습니다. MMSegmentation에서 제공되는 모델 및 데이터 셋원하는 모델, 데이터 셋이 있다면 구현하여 추가한다면 기존 모델과 데이터셋에 결합하여 사용할 수 있습니다.홈페이지에서 Tutorial도 제공하여 쉽게 따라 사용할 수 있습니다.